DPU 기반 분산형 유연 스토리지 솔루션

AI 인프라에서의 고밀도 QLC SSD 부상

인공 지능이 우리 세계에 스며들면서 지금까지는 대부분 이용되지 않았던 아카이브 데이터에서 인사이트를 이끌어내고 있습니다. 그 결과, 한 때는"흥미롭지 않거나"잠잠했던 스토리지 계층이 이제"주목을 받으면서" 이렇게 방대한 과거 데이터 보관소를 활용하고 그로부터 배우고자 하는 경쟁을 야기하고 있습니다. 전통적으로 하드 디스크 드라이브(HDD)는 아카이브 스토리지의 핵심 역할을 하며 이렇게 흥미롭지 않은 계층의 요구 사항을 능숙하게 다루어 왔습니다. 그러나 AI 모델과 GPU 워크로드에 필요한 데이터 접근량이 증가함에 따라 HDD의 한계가 명확해졌습니다.

HDD 성능은 이제 더 이상 신속한 데이터 추출과 전송 요구에 따라가지 못합니다. 게다가, HDD는 데이터 밀도 측면에서 인상적인 성과를 거두었지만, 시장 점유율이 확대되고 있는 고밀도 쿼드 레벨 셀(Quad-Level Cell ,QLC) SSD와 비교하면 여전히 뒤처집니다. QLC SSD는 더 높은 저장 밀도를 제공할 뿐만 아니라 HDD 상대 대비 랙 공간을 크게 줄이고 전력 효율성을 향상시킵니다. 이러한 기술적 우위로 인해 고밀도 QLC 드라이브로의 눈에 띄는 산업 변화가 일어나고 있습니다.

솔리드 스테이트 스토리지는 싱글 레벨 셀(Single-Level Cell, SLC)에서 멀티 레벨 셀(Multi-Level Cell, MLC), 트리플 레벨 셀(Triple-Level Cell, TLC), 그리고 이제는 QLC 아키텍처로 진화하는 놀라운 변화를 겪어 왔으며, 연이은 도약을 통해 단일 메모리 셀에 더 많은 비트의 데이터를 저장할 수 있게 되었습니다. 2차원 평면 NAND에서 3차원 적층 NAND로의 전환은 저장 용량을 더욱 증폭시켰습니다. 오늘날의 NAND 칩 적층의 높이는 흔히 300층을 넘습니다. 엔터프라이즈 영역의 주류인 단일 디스크 SSD는 이제 61.44TB 및 122.88TB의 용량을 제공하며, 훨씬 더 큰 용량의 드라이브가 곧 출시되어 고성능, 고용량 아카이브 스토리지의 새로운 시대를 열게 됩니다.

하이브리드 스토리지 솔루션 대비 QLC의 이점

16PB 네트워크 결합 스토리지(Network Attached Storage, NAS)를 사용하여 50MW 전력 예산을 처리할 때, 그림 1은 모든 QLC 스토리지 솔루션과 TLC+HDD 솔루션을 비교한 결과를 보여줍니다.

그림 1. 스토리지 장치 유형이 랙 공간과 전력 소모량에 미치는 영향

그림 1. 스토리지 장치 유형이 랙 공간과 전력 소모량에 미치는 영향

기존의 TLC 및 HDD 하이브리드 아키텍처와 비교하면 전체 QLC 고용량 어레이는 스토리지 전력 소모를 약 90%까지 줄이면서 동일한 스토리지 용량을 제공합니다. 뿐만 아니라, 필요한 랙 수가 눈에 띄게 줄어 공간을 8배 더 넓게 활용할 수 있습니다. 디스크 드라이브 수가 줄어들면 스토리지 장비의 전체 무게도 감소하여 데이터 센터 바닥의 하중 지지 요구 사항을 훨씬 낮춰 줍니다. QLC 아키텍처는 또한 테라바이트당 스토리지의 인터페이스 대역폭을 크게 향상시킵니다. 상세 내용 및 전제 조건은 부록 A를 참조하십시오.

| 성능 파라미터 | 30TB Exos M HDD | 122.88TB Solidigm™ D5-P5336 QLC |

| 순차 쓰기 | 262MB/s | 3000MB/s |

| 순차 읽기 | 275MB/s | 7000MB/s |

| 랜덤 쓰기 | 350 IOPS | 19,000IOPS |

| 랜덤 읽기 | 170 IOPS | 900,000IOPS |

표 1. HDD와 Solidigm D5-P5336 QLC SSD의 성능 비교

표 1은 30TB HAMR HDD1 와 Solidigm D5-P5336 122.88TB QLC SSD의 읽기/쓰기 성능을 비교합니다.2 일반적으로 QLC SSD는 HDD보다 읽기/쓰기 속도가 현저하게 빠르고 훨씬 높은 밀도를 제공합니다. 최신 AI 데이터 센터 및 페타바이트 규모의 스토리지를 배포하는 클라우드 데이터 센터의 경우, 전체 QLC 플래시 어레이가 제공하는 테라바이트당 대역폭은 HDD 기반 어레이보다 훨씬 큽니다. 즉, 올플래시 어레이를 사용하면 동일한 크기의 데이터 블록을 읽는 데 소요되는 시간이 현저하게 단축되어 GPU에 맞춰 스토리지 인프라를 구축할 수 있고 GPU 유휴 시간을 줄일 수 있습니다.

고용량 SSD DRAM 크기 관련 기술적 난제

QLC SSD는 수많은 장점을 제공합니다. 하지만 QLC의 용량이 커짐에 따라 간접 처리 장치(Indirection Unit, IU) 크기도 기존의 4K에서 16K ~ 64K로 점차 커지고 있습니다. 이는 엔터프라이즈급 SSD 컨트롤러의 DRAM 용량이 전력 예산에 의해 제한되기 때문이며, DRAM은 일반적으로 논리적 주소를 물리적 주소로 매핑하는 플래시 변환 계층(Flash Translation Layer, FTL) 테이블을 저장하는 데 사용됩니다. 디스크 용량이 늘어남에 따라 FTL 항목 수가 증가하여 DRAM 용량도 더 많이 필요합니다. 이는 비용과 실행 측면에서 어려움을 제기합니다. 그 결과, 많은 제조업체에서 FTL 항목 수를 줄이기 위해 IU 크기를 늘리는 방식을 선택했으며, 그렇게 함으로써 드라이브가 사용하는 유효한 DRAM 용량을 저용량 SSD와 비슷하게 유지하고 있습니다.

QLC SSD IU 크기는 증가하고 있지만 소프트웨어 스택은 이러한 변화에 적응하지 못하고 있습니다. 여전히 더 작은 간접 처리 장치를 사용하도록 설계된 기존의 스토리지의 원리에 따라 작동합니다. 이러한 불일치는 쓰기 증폭 계수(Write Amplification Factor, WAF)를 높일 가능성이 있으며, 결과적으로 QLC SSD의 수명에 부정적인 영향을 줍니다. 예를 들어, 애플리케이션이 64K IU 크기의 SSD에 4K 데이터 블록을 기록해야 하는 경우, 실제로 기록되는 데이터의 양은 64K이므로, 소량의 데이터 기록에 대한 WAF는 64/4 = 16이 됩니다. OS 메모리 페이지는 보통 크기가 4K이므로, 최적화 성능이 부족하면 4K의 쓰기 작업마다 데이터 양을 16배 증폭시켜 내구성과 속도를 떨어뜨립니다.

스토리지 소프트웨어 업체는 대용량 IU SSD의 IU 크기에 맞춰 스토리지 스택을 최적화해 왔습니다. 중소기업(Small and Medium-sized Enterprise, SME)에서도 이러한 기능을 활용할 수 있도록 Solidigm은 고용량 QLC SSD의 구현을 가속화하는 것을 목표로 클라우드 스토리지 가속 레이어(Cloud Storage Acceleration Layer, CSAL)를 통해 쓰기 형태 기능을 오픈소스로 공개해 왔습니다.

IU 정렬을 위한 CSAL 호스트 기반 FTL

CSAL은 특히 다양한 워크로드 상황에서 고밀도 NAND 플래시 SSD의 성능과 내구성을 최적화하도록 설계된 호스트 기반 플래시 변환 계층(Flash Translation Layer)입니다.

그림 2. CSAL 소프트웨어의 시스템 아키텍처

그림 2. CSAL 소프트웨어의 시스템 아키텍처

그림 2에서 보는 바와 같이 CSAL은 계층형 스토리지 아키텍처를 채택하여 Solidigm D7-PS1010과 같은 고성능 스토리지 미디어를 프론트엔드 캐시 및 쓰기 버퍼로 활용합니다. 이를 통해 호스트의 소규모 무작위 쓰기 작업을 하위의 고용량 QLC SSD에 대한 대규모 순차 쓰기 작업으로 변환합니다. 이 과정에서는 애플리케이션 계층에서 소규모 쓰기 작업을 QLC SSD의 간접 처리 장치보다 크거나 같은 블록 크기로 종합하여 IU 정렬을 이룹니다. 이러한 변환은 WAF를 크게 줄이고, 플래시 메모리의 수명을 늘리며, 처리량을 향상시키면서 지연 시간을 단축시킵니다.

읽기 작업은 QLC SSD가 제공하는 TLC와 동등한 고속 읽기 대역폭을 활용하여 캐시 또는 QLC에서 이루어질 수 있습니다.

AI 파이프라인의 다양한 단계별로 필요한 저장 용량이 상당히 다릅니다. 예를 들어, AI 학습 과정에서는 체크포인트 파일과 같은 임시 데이터가 대량으로 자주 저장됩니다. 이 단계에서 스토리지 장치는 대용량 데이터 블록의 많은 순차 쓰기 작업을 처리해야 하며, 이러한 작업에는 QLC SSD가 적합합니다. 그러나 AI 추론 단계에서는 검색 증강 생성(Retrieval Augmented Generation, RAG) 방식을 널리 채택하여 벡터 데이터베이스가 많이 사용되고 있습니다. 이 시점에서 스토리지 장치는 많은 소규모 무작위 쓰기 작업을 처리해야 합니다.

데이터 I/O 패턴이 빈번하게 변화하는 다양한 I/O 크기의 애플리케이션 요구 사항에 더 잘 부합하기 위해 CSAL을 통한 DPU 네이티브 방식의 유연한 분리형 스토리지 솔루션을 도입합니다.

CSAL을 통한 DPU 네이티브 방식의 유연한 분리형 스토리지 솔루션

그림 3. CSAL 유연한 스토리지 솔루션

그림 3. CSAL 유연한 스토리지 솔루션

그림 3에서는 유연한 스토리지 솔루션을 달성하기 위해 CSAL이 DPU에 오프로드되는 방법을 보여줍니다. 이 샘플 솔루션은 캐시 드라이브와 용량 드라이브에 대해 별도의 스토리지 노드를 사용하여 스토리지와 컴퓨팅을 분리하는 방법을 보여줍니다.

- 스토리지 노드는 DPU를 통해 NVMe-oF 타겟으로 노출됩니다.

- DPU API를 사용하여 CSAL 소프트웨어가 DPU에 설치됩니다.

- CSAL은 논리-물리 주소(L2P) 매핑을 저장하기 위해 DPU DRAM과 같은 DPU 리소스를 활용하고, FTL을 실행하기 위해 DPU 코어를 활용합니다.

- DPU 오프로딩은 스토리지 처리에 소모되는 호스트 DRAM 및 CPU 리소스를 확보합니다.

- CSAL은 호스트에서 캐시와 용량 드라이브를 추출하여 NVMe-oF를 통해 원격 스토리지로 애플리케이션에 노출시킵니다.

이 섹션에서는 이 솔루션의 구성 요소에 대해 더 자세히 설명합니다.

1. 데이터 처리 장치(Data Processing Unit, DPU)

DPU 카드의 컴퓨팅 리소스는 FTL의 L2P 테이블 룩업 및 사용자 데이터 블록 병합과 같은 경량 CSAL 소프트웨어의 스토리지 컴퓨팅 요구 사항을 효과적으로 지원할 수 있습니다. 또한, DPU 카드의 DRAM 리소스를 사용하여 FTL 테이블 내용의 일부를 저장할 수 있습니다. CSAL은 DPU 카드의 리소스를 활용하여 호스트 CPU와 메모리의 사용량을 성공적으로 감소시킴으로써 비즈니스 관련 서비스에 더 잘 활용될 수 있도록 지원합니다. 또한, 고급형 DPU가 스토리지 처리를 위해 더 많은 DRAM 메모리 리소스를 갖춘 경우에는 고성능 캐시 디스크 대신 DPU DRAM을 사용하도록 CSAL 소프트웨어 내의 구성 옵션을 수정하여 소프트웨어 내의 캐싱 기능을 구현할 수 있습니다. 이 설계는 메모리 활용 및 구성 측면에서 유연성을 제공합니다.

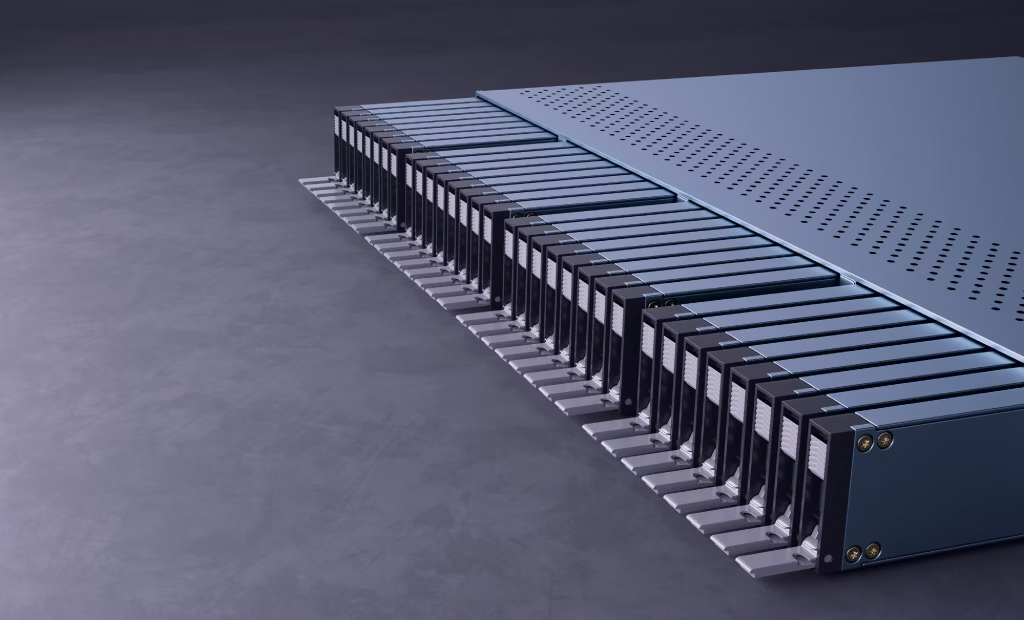

2. 스토리지 노드

스토리지 노드는 고속 TLC 캐시 디스크와 고밀도 QLC 용량 디스크의 조합이 될 수 있는 솔리드 스테이트 드라이브 기반 올플래시 어레이로 구성됩니다. 각 스토리지 노드에는 여러 개의 DPU 카드가 있습니다. 이러한 카드는 호스트에 NVMe-oF 기반 타겟을 제공합니다. 스토리지 노드는 다중 경로 액세스 모드를 채택하여 스토리지 네트워크에 연결합니다. 이는 데이터 I/O 대역폭을 향상시킬 뿐만 아니라 단일 장애 지점을 방지합니다.

3. 컴퓨팅 노드

일반적으로 컴퓨팅 노드 서버는 높은 연산 수요를 충족하기 위해 다수의 GPU와 DPU를 갖추고 있습니다. DPU 인프라는 아직 초기 단계임에도 불구하고 점점 더 많이 보급되고 있습니다. 현재 DPU 처리 능력이 충분히 활용되고 있지는 않지만, 많은 애플리케이션이 호스트 컴퓨팅의 부하를 줄이기 위해 DPU가 제공하는 처리 능력을 이용하는 방향으로 발전하고 있습니다. CSAL이 정확히 그런 역할을 합니다. 당사는 CSAL 소프트웨어 모듈을 컴퓨팅 노드의 CPU에서 DPU 카드로 옮겼습니다. 이를 통해 네트워크 전송 중에 데이터 처리 속도가 더 빨라지고 유휴 상태였던 DPU 리소스 활용을 극대화할 수 있습니다.

4. 소프트웨어 정의 유연한 스토리지

DPU 하드웨어와 NVMe-oF 프로토콜 활용을 통해 CSAL은 단일 머신부터 유연한 크로스 네트워크 스토리지 솔루션에 걸쳐 폭넓게 지원할 수 있습니다. 올플래시 어레이(“단일 플래시 박스” 또는 “JBOF”) 스토리지 노드는 네트워크를 통해 여러 개의 NVMe-oF 타겟을 제공합니다. 데이터 센터 관리 소프트웨어는 다양한 단계 및 인공 지능 컴퓨팅의 요구 사항에 따라 스토리지 용량과 기능을 유연하게 구성할 수 있습니다.

AI 파이프라인에 CSAL을 활용한 사례

이 섹션에서는 AI 파이프라인의 다양한 단계에서 CSAL 스토리지의 유연성을 활용할 수 있는 방법을 보여주는 몇 가지 예시와 함께 살펴보겠습니다. AI 컴퓨팅 단계는 각각 다른 I/O 패턴을 가지고 있습니다. 아래에 제시된 예시에서는 AI 파이프라인의 여러 단계 요구 사항을 지원하는 다양한 볼륨을 생성하기 위해 CSAL을 사용하는 방법을 보여줍니다.

예시 1

이 예시에서는 CSAL FTL이 Solidigm 122TB QLC SSD에 배포된다고 가정합니다. 컴퓨팅 노드가 데이터 수집 및 체크포인트 단계를 위해 200TB의 스토리지 공간을 필요로 하는 경우, 관리 소프트웨어는 CSAL에 컴퓨팅 노드의 DPU에 두 개의 NVMe-oF 타겟으로 구성된 가상 디스크를 생성하도록 지시할 수 있습니다. 이러한 단계에는 대규모 순차 쓰기 작업이 포함되므로 캐시 디스크는 선택 사항입니다. DPU의 DRAM은 파일 시스템에 의해 할당된 4K 데이터 블록의 작은 부분을 QLC 고용량 디스크에 직접 기록하기 전에 큰 순차 블록으로 통합하는 데 활용할 수 있습니다.

예시 2

이 예시에서는 컴퓨팅 노드가 추론 서버라고 가정해 봅시다. 추론 단계에는 읽기와 쓰기 접근 권한이 혼합되어 구성된 I/O 패턴이 있으며, 이는 작고 무작위적입니다 . 검색 증강 생성(Retrieval Augmented Generation, RAG) 방식은 추론 기법 중 하나입니다. 벡터 데이터베이스가 RAG 시스템의 핵심 구성 요소입니다. 벡터 데이터베이스를 저장할 200TB의 스토리지 공간을 만들기 위해 관리 소프트웨어는 컴퓨팅 노드의 DPU에 16TB의 캐시 타겟과 두 개의 122TB QLC 타겟으로 구성된 CSAL 가상 디스크를 생성할 수 있습니다. 그런 다음 이 가상 디스크에 벡터 데이터베이스를 저장합니다. 벡터 데이터베이스의 I/O 패턴에는 작은 블록 단위의 무작위 읽기/쓰기 작업이 포함되기 때문에 캐싱에 사용되는 고성능 타겟은 작은 I/O 를 간접 처리 장치에 정렬하고 후속 QLC 타겟에 기록하기 전에 이를 큰 데이터 블록에 병합하는 작업을 관리합니다.

데이터 센터는 DPU와 CSAL 소프트웨어를 도입함으로써 모든 스토리지 디스크를 더욱 효율적으로 활용하고, 필요에 따라 스토리지 리소스를 유연하게 구성, 생성 및 해제할 수 있습니다.

테스트 토폴로지

QLC SSD의 간접 처리 장치에 대한 I/O 정렬을 통해 달성한 성능 개선 및 DPU 기반 CSAL을 통한 유연한 스토리지 솔루션을 입증하기 위해 당사는 그림 4에서 보는 바와 같이 당사 연구소에 다음과 같은 테스트 환경을 구축했습니다.

그림 4. CSAL+DPU 테스트베드

그림 4. CSAL+DPU 테스트베드

그림 4에서 ①과 ②는 고용량 QLC 솔리드 스테이트 드라이브이고, ③은 고성능 TLC 캐시 디스크입니다. ④와 ⑤는 DPU 네트워크 및 네트워크 스위치를 통해 기반 물리 디스크를 결합하여 생성된 가상 NVMe-oF 디스크입니다.

테스트 환경에서 스토리지 노드의 DPU는 솔리드 스테이트 드라이브를 NVMe 타겟으로 변환하는 데 사용되며, 변환된 후에는 네트워크를 통해 컴퓨팅 노드에 노출됩니다. 비교 테스트를 위해 ①(고용량 QLC 솔리드 스테이트 드라이브)을 독립형 가상 디스크 ④로 매핑하고, ②와 ③을 CSAL 소프트웨어를 사용하여 가상 디스크 ⑤로 매핑했습니다. 그런 다음 일반적인 스토리지 스트레스 테스트 소프트웨어인 FIO를 사용하여 두 개의 가상 디스크에 대한 스토리지 성능 테스트를 수행했습니다.

테스트 과정 도중에는 다양한 인공 지능 단계의 블록 크기 요구 사항을 충족하기 위해 쓰기 데이터 블록 크기, 쓰기 큐 깊이 및 쓰기 패턴을 다른 조합으로 다양화했습니다. 예를 들어, 데이터 준비 및 체크포인트 과정은 1번 테스트에 해당하는 대용량 데이터 블록 쓰기 작업을 포함하는 반면, 벡터 데이터베이스와 로그 선행 기록 애플리케이션은 4번 테스트에 해당하는 빈번한 4K 무작위 데이터 쓰기 작업을 포함합니다. 아래 그림 5에서 해당 테스트에 대한 테스트 결과를 보여드리겠습니다.

테스트 결과

그림 5. 테스트 데이터 비교

그림 5. 테스트 데이터 비교

앞서 언급한 테스트 환경을 기반으로 고속 캐시 디스크와 고용량 QLC 디스크로 구성된 독립형 고용량 QLC 디스크와 CSAL 가상 디스크 모두에서 다섯 가지 성능 테스트를 수행했습니다. 이러한 다섯 가지 테스트의 I/O 패턴은 인공 지능 컴퓨팅의 몇 가지 다른 단계에 해당합니다.

데이터 정제

학습 도중 체크포인트

오브젝트 스토리지

로그 선행 기록

데이터 준비

RAG

테스트 결과에 따르면, 소규모 4K 쓰기 작업의 경우, 무작위 방식이든 순차 방식이든 CSAL 가상 디스크가 독립형 QLC SSD에 비해 성능이 약 20배 향상된다는 점을 보여줍니다. 불균등 무작위 분포인 Zipf 테스트에서는 핫 데이터의 캐싱 효과로 인해 CSAL 솔루션 또한 독립형 QLC 솔리드 스테이트 드라이브보다 15배 향상된 성능을 보여줍니다.

Gen4 QLC SSD의 쓰기 작업 성능이 HDD보다 10배 이상 뛰어나기 때문에 HDD를 사용하는 것에 비해 독립형 QLC SSD를 사용한 결과가 훨씬 우수하다는 점에 주목해야 합니다. 우리의 테스트 결과에 따르면, CSAL과 같은 최신 스토리지 소프트웨어 솔루션을 사용하는 것이 중요한데, 이는 솔리드 스테이트 스토리지의 기본 원시 성능의 이점을 활용하여 AI 인프라의 수요를 충족하면서 동시에 스토리지 용량 확장 및 구성의 유연성을 제공할 수 있기 때문입니다.

결론

AI 애플리케이션이 계속해서 증가함에 따라 대량의 데이터를 컴퓨팅에 신속하게 가져오는 데 있어 빠르고 유연한 스토리지가 AI 인프라의 중요한 구성 요소입니다. 최신 AI 인프라는 스토리지와 컴퓨팅의 분리를 제안하고, 추론 애플리케이션은 프리필-디코드(prefill-decode, PD) 분리를 제안하는데, 두 가지 모두 스토리지 유연성에 대해 많은 것을 요구합니다.

본 연구 결과는 AI 추론 애플리케이션에서 CSAL과 DPU의 조합이 객체 스토리지 및 벡터 데이터베이스의 스토리지 성능과 용량 요구 사항을 원활하게 지원할 수 있다는 점을 입증합니다. CSAL 플러스 DPU 솔루션은 대규모 데이터 센터에서 필요에 따라 스토리지 자원을 보다 유연하게 할당할 수 있도록 하여 네트워크 및 스토리지 분야의 고객 투자를 극대화하는 것을 목표로 합니다.

저자 소개

Wayne Gao는 Solidigm의 수석 엔지니어 겸 솔루션 스토리지 아키텍트입니다. 그는 경로 탐색에서 상용화에 이르기까지 Solidigm의 CSAL(클라우드 스토리지 가속화 계층)을 담당했습니다. Wayne은 20년 넘게 스토리지 개발자로서 경력을 쌓아 왔으며 미국 특허 출원/승인 4건을 보유하고 있으며, EuroSys 논문 저자이기도 합니다.

Bo Li는 Solidigm의 수석 스토리지 솔루션 설계자입니다. 여러 조직에서 20년 이상 시스템 설계 및 개발 경험을 쌓았고, 전문 분야는 네트워크 및 스토리지 솔루션의 성능 최적화입니다. 최근 몇 년 동안에는 비휘발성 스토리지 기술의 업계 전반 채택율을 높이는 업무에 집중했습니다.

Sarika Mehta는 Solidigm의 선임 스토리지 솔루션 아키텍트이며, 인텔 스토리지 부서와 Solidigm에서 쌓은 16년 이상의 경력을 보유하고 있습니다. Solidigm 고객 및 파트너와 긴밀히 협력하여 비용과 성능을 위해 스토리지 솔루션을 최적화하는 데 중점을 둡니다. 직접 연결된 스토리지에서 계층형 및 비계층형 분리 스토리지 솔루션에 이르기까지 다양한 스토리지 배포에서 다양한 스토리지 사용 사례에 대해 Solidigm SSD를 튜닝하고 최적화하는 역할을 담당합니다. 그녀는 검증, 성능 벤치마킹, 경로 검색, 기술 마케팅, 솔루션 아키텍처 분야에서 다양한 스토리지 배경을 보유하고 있습니다.

참고

2. https://www.solidigm.com/products/data-center/d5/p5336.html#form=U.2%2015mm&cap=122.88TB

부록 A: QLC와 HDD의 전력 효율 비교

출처 – Solidigm, 2024년 10월. 기타 정보 리소스는 아래에 언급된 바와 같음.

범위: 전력 소모량 분석은 최첨단 전력 및 공간 최적화 기술을 활용하는 그린필드(신규) 하단 범위 하이퍼스케일러와 2등급 AI 데이터 센터 구축을 가정합니다. 핵심 모델 파라미터는 다음과 같습니다.

총 사용 가능한 데이터 센터 에너지 용량을 50MW로 가정

각 Nvidia DGX H100 랙이 16,000TB의 스토리지 용량과 호환. NetApp AI Pod와 DGX H100 시스템 참조 아키텍처의 대략적인 중간 지점을 기반으로 하는 목표 스토리지 용량(https://docs.netapp.com/us-en/netapp-solutions/ai/aipod_nv_architecture.html#netapp-ai-pod-with-dgx-h100-systems)

NVIDIA H100 서버의 중요 IT 장비 전력 소비량 = 11,223W, 서버가 4개인 DGX H100 랙 = 44,448W

(출처 - https://www.semianalysis.com/p/ai-datacenter-energy-dilemma-race)

NVMe/HDD NAS 스토리지 구축 세부 정보:

a. TLC + HDD: 성능 계층에 TLC 10%, 객체 계층에 HDD 90%로 용량 배포. Supermicro A+ Server 1124US-TNR 기반 TLC 스토리지 서버, U.2 규격 7.68TB 용량 SSD 12개 장착 가능(https://www.supermicro.com/en/Aplus/system/1U/1124/AS-1124US-TNR.cfm). Supermicro 스토리지 SuperServer SSG-640SP-DE1CR90 기반 HDD JBOD, 드라이브 용량이 30TB인 3.5인치 HDD 90개 장착 가능(https://www.supermicro.com/en/products/system/storage/4u/ssg-640sp-de1cr90). HDD 작동 주기 100%으로 추정. TLC 유효 전력 = 20W, 유휴 전력 = 5W. HDD 유효 10R/90W 전력 = 9.8W, 유휴 전력 = 6W. 중복 아키텍처는 Hadoop의 3중 복제 방식(복사본 3개)

b. 전체 QLC: 스토리지 서버에 QLC 용량의 16%, JBOF에 QLC 용량의 84% 배포됨. Supermicro A+ 서버 1124US-TNR 기반 QLC 스토리지 서버, U.2 규격 122.88TB 용량 SSD 12개 장착 가능(https://www.supermicro.com/en/Aplus/system/1U/1124/AS-1124US-TNR.cfm). Supermicro 스토리지 SuperServer SSG-136R-4MU32JBF 기반 QLC JBOF, 드라이브 용량 122.88TB의 NVMe SSD 32개 장착 가능(https://www.supermicro.com/en/products/system/storage/1u/ssg-136r-4mu32jbf). QLC 작동 주기 11%로 추정. QLC 활성 읽기 전력 = 24W, 유휴 전력 = 5W. 중복 아키텍처는 RAID 1 미러링 방식(복사본 2개)

부록 B: 테스트 시스템 구성

| 테스트 시스템 구성 | |

| 시스템 | 제조업체: AMD 제품명: AMD EPYC 7542 32코어 프로세서 |

| BIOS | 업체: AMD Corporation |

| CPU | AMD EPYC 7542 32코어 프로세서 |

| 2.9GHz 소켓 1개, 소켓당 코어 32개 | |

| NUMA 노드 | 4 |

| DRAM | 2667MT/S에서 총 440GiB DDR4 |

| OS | Rocky Linux 9.6 |

| 커널 | Linux d3.d3 5.14.0-503.14.1.el9_5.x86_64 |

| SSD | 4 x Solidigm D5-P5336 15.36TB, 펌웨어 버전: 5CV10302, PCIe Gen4x4 4 x Solidigm D7-PS1010 3.84TB, 펌웨어 버전: G70YG030, PCIe Gen5x4 |

| Fio | 버전: 3.39 |

| DPU | MT43244 BlueField-3 |

표 2. 시스템 구성

부록 C: 참조 리소스

Solidigm D5-P5336 사양 https://www.solidigm.com/products/data-center/d5/p5336.html

CSAL Tech Field Day 발표 https://www.youtube.com/watch?v=tAdQC5G0S8o

오픈 소스 CSAL 문서 https://spdk.io/doc/ftl.html